Olivier Lambert

4/05/2017

Commentaire: (...) Il est devenu la base de beaucoup de décisions politiques, et est même inclus au sein des programmes de candidats lors de l’élection présidentielle.[...] On voit ici que négaWatt, en décidant de se séparer du nucléaire dès le départ, doit tordre la réalité au maximum pour « rentrer dans les cases » : il faut réduire énormément la consommation pour pouvoir utiliser uniquement du renouvelable. Le problème, c’est que ces économies ne sont même pas suffisantes ! On l’a vu pour l’éolien, les chiffres ne sont pas réalistes. Sans oublier la contrainte du stockage qui est loin d’être résolue à l’heure actuelle.

Comment l'association négaWatt au scénario qu tord la réalité au maximum pour être "crédible" a t-elle l'oreille de nos politiques?

php

Il

est devenu la base de beaucoup de décisions politiques, et est même

inclus au sein des programmes de candidats lors de l’élection

présidentielle. Naturellement, il m’est apparu utile d’analyser ce

scénario. Les chiffres sont-ils cohérents ? Les préconisations

sont-elles alignées avec les intentions initiales qui sont :

réduire le réchauffement climatique, sécuriser l’approvisionnement

énergétique et éviter des conséquences sanitaires sur la population ?

Des intentions toutes très louables !

Avant toute chose, je tiens à remercier Gilga et Guru pour leur aide, et Étienne pour sa relecture très rigoureuse des sources et des chiffres.

Le rapport en question est disponible ici : https://negawatt.org/IMG/pdf/synthese_scenario-negawatt_2017-2050.pdf

Avertissement : je ne travaille aucunement dans l’industrie électrique, que cela soit du nucléaire ou éolien, je n’ai aucune action chez AREVA, EDF, Vinci etc. À préciser qu’Étienne, m’ayant aidé pour les données et les sources sur la partie ingénierie nucléaire, lui, a une formation en Génie Atomique et fait actuellement une thèse au MIT dans ce domaine. Enfin, les chiffres avancés ici sont sourcés, si ce n’est pas le cas, merci de me contacter, je m’efforcerai de corriger. Les critiques sont les bienvenues, merci de rester factuel autant que possible.

Limites de l’analyse

Cette

analyse va se limiter aux questions d’approvisionnement énergétique,

puisque c’est le domaine dans lequel il est le plus simple de trouver

des chiffres et de valider le réalisme du scénario. Pour une analyse

plus complète (mais un peu ancienne), vous pouvez vous consulter le site

de sauvonsleclimat.org qui tente de vérifier tous les points.

Ici,

l’idée est surtout d’expliquer les concepts importants, comme le

facteur de charge, le risque de la radioactivité etc. et aussi être

amené à comparer différentes façon de produire de l’énergie à travers

des exemples illustrés.

Objectifs du rapport

Le rapport expose 3 objectifs :

- affiner les précédents rapports avec des données à jour (il existe un rapport depuis 2003, mis à jour régulièrement en 2006, 2011 et donc 2017)

- interpeller les décideurs pour leur donner une ambition

- donner des ordres de grandeurs et démontrer qu’il est possible d’atteindre des énergies 100% renouvelables en 2050

À garder en tête : ce rapport vise bien entendu la politique énergétique de la France et peut être de nos voisins directs avec lesquels nous sommes interconnectés.

Note: ce scénario s’étale sur 33 ans, et se base sur certaines prévisions, dont nous vérifierons si elles sont plausibles (autant que possible bien entendu).

Urgence numéro 1 : le changement climatique

C’est le premier point abordé par le rapport. Il souhaite limiter les conséquences du changement climatique, citant le GIEC, dont vous pouvez consulter le site ici.

Les travaux du GIEC sur le changement climatique font consensus dans la

communauté scientifique, je considère leurs prévisions sur les gaz à effets de serre et leurs conséquences comme une base de travail tout à fait valable.

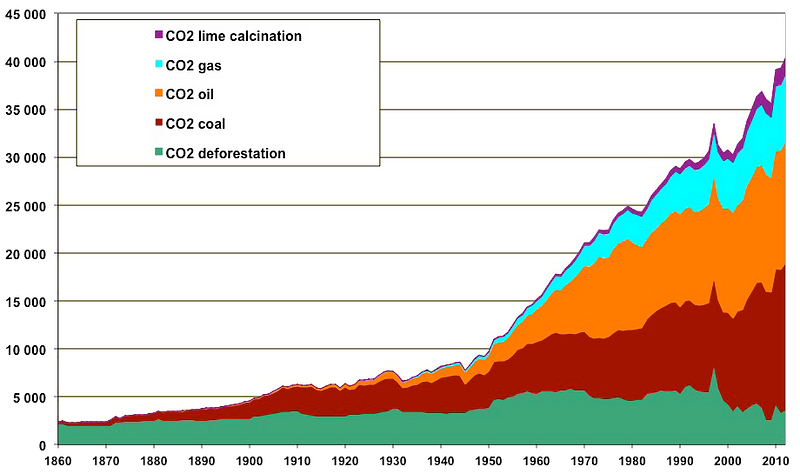

Première

surprise, le CO2 n’est pas abordé au début du rapport. Pourtant, il

s’agit de la primo-inquiétude lorsque l’on parle de réchauffement. En

effet, le changement climatique est principalement causé par les gaz à

effets de serre, dont le CO2 qui a crevé le plafond depuis que notre

monde s’industrialise massivement :

À noter la part énorme du charbon dans ces émissions, suivi de près par le pétrole.

Le vrai combat se fait donc ici : réduire le CO2 autant que possible !

Bien évidemment, sans ou avec le moins de conséquences sanitaires

directes sur la population. Il est raisonnable de penser que c’est aussi

l’objectif de négaWatt. Nous partageons donc le même constat de départ.

Quid des solutions ? Il est tentant pour ma part de penser que le chantier le plus évident serait celui de la réduction des émissions de CO2 causées par le charbon :

il n’est pas utilisé dans les transports, où remplacer le pétrole est

déjà plus compliqué, mais bien pour fabriquer de l’électricité. Or, nous

verrons qu’il est possible de créer de l’énergie électrique avec un

bilan carbone bien plus faible. Cependant, en France, nous n’utilisons

pas de charbon (mais vous verrez que nos voisins européens en abusent).

Note : l’énergie ne se produit pas, elle se transforme. Ceci étant dit dans cet article, je vais utiliser le terme « créer » ou « produire » pour plus de simplicité.

Nous verrons donc quelles solutions négaWatt propose pour cela.

Autres urgences

Tout

d’abord, la dépendance aux ressources fossiles, avec ce que cela

comporte sur le pétrole et le gaz, en terme de géopolitique : ce point n’est guère contestable concernant ces deux énergies.

Ensuite, les impacts sanitaires et les risques technologiques :

négaWatt a tout à fait raison sur l’horreur sanitaire du charbon et des

conséquences du diesel chez nous. En effet, le charbon est une

catastrophe écologique et sanitaire mais vu son coût faible, est

massivement utilisé en Europe.

Jusqu’ici, je suis entièrement d’accord avec cette introduction. Mais la suite se complique un peu…

La question du nucléaire

Pour ce qui est des risques technologiques, nous avons juste le droit à :

Au chapitre des risques technologiques, le monde n’a heureusement pas connu de nouvelle catastrophe de l’ampleur de celle de Fukushima. Toutefois, loin de répondre à sa promesse de fournir massivement l’énergie décarbonée dont le monde a besoin, le nucléaire est en déclin. En France, il est en crise profonde : entre aventures ruineuses à l’étranger, faillite de fait des acteurs industriels, perte durable de compétitivité, problèmes majeurs de qualité et découverte de falsifications graves, la sûreté des installations nucléaires vieillissantes n’a peut-être jamais été autant sujette à caution.

Ici

donc, négaWatt vient de balayer d’un revers de la main la possibilité

du nucléaire dans la lutte contre le réchauffement climatique. Pas

d’évaluation de risque, pas d’analyse de la situation, ni de l’accident

de Fukushima. Mais pourquoi ? Je n’ai pas la réponse dans le rapport. Ceci dit, en fouillant le site de négaWatt, j’ai trouvé un lien vers « Décrypter L’énergie », qui précise tout en bas (!) qu’il est « Un site animé par l’Association négaWatt ». En y regardant de plus près, l’association indique :

Les problématiques énergétiques sont exposées à de trop nombreuses idées reçues qui nuisent à l’image et au développement d’une véritable transition énergétique en France.

Qu’il en soit ainsi, combattons les idées reçues !

Cet article non plus ne traite PAS des risques spécifiques (prolifération,

accidents majeurs, déchets). Décidément, ils ne souhaitent même pas

entrer dans le détail de ce côté là, et c’est bien dommage. Pourquoi ?

Concernant

le premier argument, voici un résumé : « le nucléaire produit

effectivement peu de CO2 (4 à 110 gCO2éq/kWh) mais il est peu employé, donc

ce n’est pas un moyen efficace de lutter contre le rejet de gaz à effet

de serre ». La conclusion logique de cet argument devrait pourtant être

que le développement du nucléaire est justement un moyen efficace de

lutter contre le rejet de gaz a effet de serre. Rien dans cette

affirmation ne montre que le nucléaire n’est pas efficace dans ce rôle.

Quand à l’argumentation que le nucléaire ne participe pas ou peu à la décarbonation

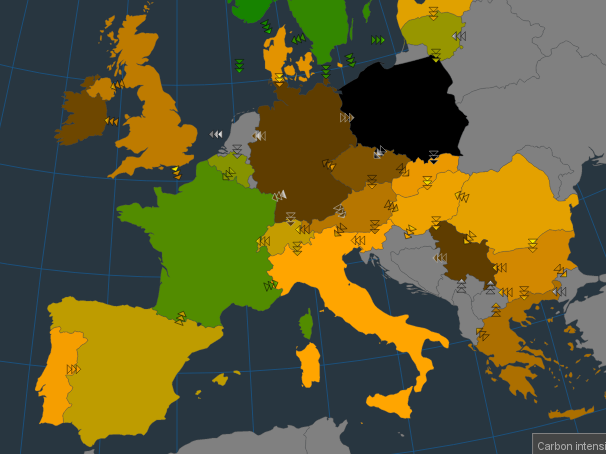

de la production d’électricité, il me semble intéressant de comparer la

situation de la France et des autres pays européens, en terme de

grammes de CO2 émis par kWh produit, avec par exemple à un instant T :

En

prenant les chiffres, quand j’ai utilisé cette carte (début janvier,

c’est à dire en hiver quand nous avons besoin de nous chauffer) :

- 111 gCO2/kWh pour la France ;

- 583 gCO2/kWh pour les allemands ;

- champion la Pologne avec 760 gCO2/kWh !

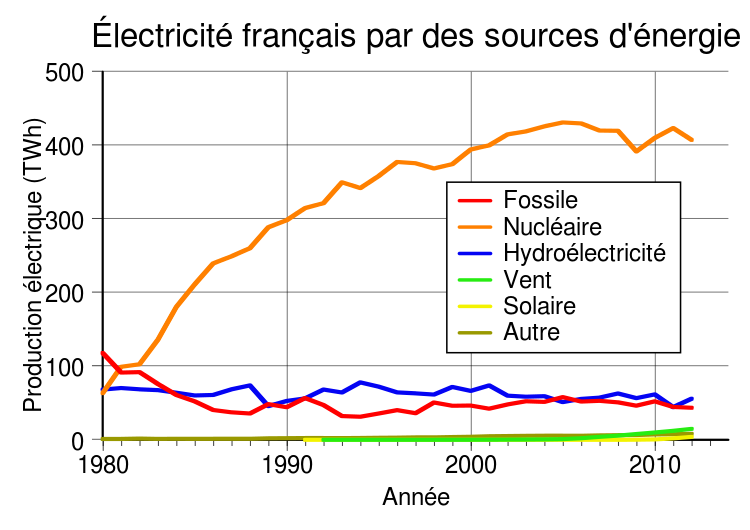

Donc

pour chaque kWh produit, les allemands émettent 5 fois plus de CO2 que

nous. Si vous prenez les chiffres à l’heure où j’écris ces lignes, le rapport de 5 fois est toujours présent. Comment est-possible ? Voici la réponse :

Le nucléaire est donc, dans le contexte Français (logement chauffé à l’électrique), particulièrement intéressant pour diminuer le CO2.

Nous avons aussi la chance d’avoir une capacité hydraulique nous

permettant de compenser quand il faut avec le nucléaire, qui pour

rappel, est pilotable mais pas à l’heure près. Par pilotable, on entend

« la capacité à décider qu’il faut produire à un instant T ». Les

chiffres et la réalité de lois de la physique sont là. Pour le

nucléaire, cela peut se faire à 2 niveaux :

- À très courte échelle temporelle, via une variation instantanée de la puissance envoyée au réseau, sans changer la puissance du réacteur (réglage de fréquence). Dans ce cas, l’amplitude est limitée ;

- En suivi de charge à plus long terme (heures/jours), avec une variation de l’ordre de 1 à 5% par heure selon le type de réacteur. L’amplitude possible s’étale entre 50% et 100% de la puissance nominale.

Concernant

la critique champ d’action limité du nucléaire à l’échelle mondiale,

pourquoi pas, mais nous parlons ici de la France, et de notre parc

installé. Pour information, plus nous utilisons nos centrales

existantes, moins le kWh est cher. En effet, une centrale est

effectivement gourmande capitalistiquement (beaucoup d’argent à la

construction, mais beaucoup moins durant l’exploitation eu égard

l’énergie fournie). Je suis d’accord avec négaWatt sur un point : le

nucléaire ne doit pas vampiriser tous les capitaux pour notre politique

énergétique. Mais c’est plutôt l’inverse qui se déroule de facto : vous

payez déjà la CSPE qui a un impact direct sur les coûts de votre

énergie, et ces 7 milliards d’euros par an dédiés au renouvelables. Pour mettre en perspective, le nucléaire coûte lui 1 milliard par an en R&D.

On pourrait aussi parler des dérives des énergies renouvelables « à

tout prix » qui peuvent s’avérer très dommageable pour la sécurité de

notre alimentation énergétique, ainsi que des dangers de la dérégulation

du marché de l’énergie. C’est pour cela qu’un acteur public dans le domaine de l’énergie est très important. C’est

uniquement grâce à cela que nous pouvons obtenir une excellente qualité

à faible coût à condition d’investir massivement sur le long terme, ce

qui a été fait en France. D’ailleurs, l’essentiel de ce que l’on paye

dans la facture est le remboursement d’un investissement de départ,

d’environ 2G€/GWe. Le nucléaire permet d’être relativement indépendant du coût de marché du combustible

(qui n’intervient que pour 7% du prix de l’électricité, valeur 2010).

Et enfin, cela ouvre sur la perspective de la surgénération qui permet

d’utiliser nos propres stocks d’U-238 issu de l’enrichissement, mais qui

implique des compétences technico-économiques qui ne s’improvisent pas.

On perdrait tout l’effort investi dans cette filière en l’abandonnant.

Mais quid des risques technologiques du nucléaire alors ? Je n’aurai pas d’état d’âme à militer pour l’abandon de la filière nucléaire si elle se trouve trop dangereuse pour le public.

Ici, pas d’idéologie, je m’efforce de chercher des faits quantifiables

autant que possible. J’ai donc creusé la question en détail depuis

quelques années.

Retour à Fukushima

En premier lieu, je vous invite à consulter le très complet rapport de l’ISRN. Pour les plus pressés, lisez directement la suite.

Pour

rappel, Fukushima a été le pire des scénarios du nucléaire concevable,

LE CAUCHEMAR TOTAL pour n’importe quel exploitant de centrales

nucléaires. Avant l’accident, les germes de la catastrophe sont déjà

semés :

- une architecture globale de centrale à revoir déjà à l’époque (protections anti-tsunami sous-estimées, générateurs au sol et non en hauteur, pas de système de recombinaison de l’hydrogène contrairement à chez nous) ;

- un exploitant (TEPCO) qui semble prendre ses aises avec la réglementation et le manque de surveillance à son égard par les autorités.

Nous

avons ici deux problèmes, remontant à un cause politique (manque de

volonté de mettre à jour la centrale et connivences probables entre les

politiques et l’exploitant privé). Pour ceux qui souhaitent des détails sur ces premiers problèmes, je vous invite à lire Fukushima: The Story of a Nuclear Disaster de David Lochbaum.

À noter qu’en France, cela nous permet de garder en tête que c’est

l’État qui doit rester maître, il est difficile de faire confiance à des

acteurs 100% privés, sauf à les encadrer très fortement.

Le

jour J à Fukushima, patatras ! Un séisme qui fait stopper les réacteurs

(comme prévu) mais surtout par la suite, un tsunami dantesque dont on

connait les proportions, va noyer la centrale. Avec comme conséquence

dans les jours qui suivent :

- plusieurs réacteurs en même temps connaissent la pire défaillance possible (défaut de refroidissement entraînant radiolyse, fusion des cœurs et destruction du confinement) ;

- le tout dans un contexte général de crise nationale extrême, avec des infrastructures détruites de partout (du fait du séisme et du tsunami).

Quel

bilan pour ce scénario catastrophique ? Un rapide bilan, tiré du

rapport de l’ISRN : tous les rejets disséminées (7e18 Bq de Xe, 4e17 Bq

d’I-131/132, 1e17 Bq de Te, 6e16 Bq de Cs-134/136/137, 3e16 d’autres

choses) vont faire zéro mort mesurable dans la population : formulé

autrement et plus prosaïquement, il n’y a pas eu d’exposition

suffisante pour générer un excès statistique de cancers qui soit

détectable dans les décennies à venir. La

contamination dans les zones évacuées représente -en terme

d’irradiation- ce qui est autorisé pour les travailleurs du nucléaire (ce

qui empêche d’y retourner y vivre à court terme, mais qui n’engendre

pas de conséquences sanitaires lors de l’évacuation). Les dommages

environnementaux direct (faune et flore) sont faibles, bien que de de

nombreuses études continuent de se porter là dessus, avec en élément de

comparaison l’accident de Tchernobyl en 1986. Les plus courageux pourront se faire une idée en lisant ce récapitulatif.

Le

pire dégât résulte de l’évacuation des populations (110 000 personnes

dans un rayon de 20 km) et l’abandon de milliers d’animaux. Cela fait

donc réfléchir pour augmenter le taux d’activité commandant les

évacuations afin de limiter ces zones à des plus petits périmètres.

Parenthèse sur la radioactivité

Voici de quoi donner quelques ordres d’idée concernant la radioactivité.

Par

exemple, la norme de consommation alimentaire est au maximum de 0,5

kBq/kg. Au dessus, c’est interdit. Ça, c’est la norme. Mais il ne faut

surtout pas confondre dépassement de la norme et zone de danger. De

façon assez compréhensible, pour tout ce qui concerne la santé publique,

on calcule large. Très large même, surtout si ça ne coûte rien (doctrine ALARA).

Concrètement, on a pêché des poissons jusqu’à 120 kBq/kg dans la baie de Fukushima, soit 240 fois la norme ce qui semble assez flippant de prime abord (j’ai eu cette réaction effectivement !). Les chiffres sont disponibles ici.

Concrètement, on a pêché des poissons jusqu’à 120 kBq/kg dans la baie de Fukushima, soit 240 fois la norme ce qui semble assez flippant de prime abord (j’ai eu cette réaction effectivement !). Les chiffres sont disponibles ici.

Faisons donc un calcul pour le facteur de dose

du césium: je vais utiliser le Cs-137, qui est le plus abondant, mais

le calcul est très facile à adapter pour un mélange Cs-134 et Cs-137 :

Le facteur de dose en ingestion du Cs-137 est de 0,014 mSv/kBq .

Soit ici 0,014 * 120 = 1,7 mSv par kg de poisson ultra-contaminé ingéré.

La dose efficace (en Sievert) a partir de laquelle on commence à craindre effectivement pour la santé, c’est à dire de manière constatée et mesurable dans des études sur de grandes populations permettant d’avoir une bonne puissance statistique dans l’évaluation du risque, est de 100 mSv en une seule prise (ou 200 mSv/an si la dose est étalée sur l’année). Avec cette dose là, le nombre de cancer induit est de l’ordre de +0,5% (la règle de proportionnalité est de P = 0,05 D, avec P la proportion de cancer radioinduits et D la dose en Sivert). Concrètement, si je prend 1000 personnes exposées à moins de 100 mSv, j’aurais estimé 400 cancers (c’est en gros le nombre de personnes qui développeront un cancer à la base), sur une vie entière contre 405 si elles sont exposées à 100 mSv .

Avec un poisson farci au taux de 120 kBq/kg, il faut en absorber 60 kg rapidement (au minimum dans l’année) pour arriver au seuil de 100 mSv où on commence à se préoccuper d’un effet possible sur la santé.

Soit ici 0,014 * 120 = 1,7 mSv par kg de poisson ultra-contaminé ingéré.

La dose efficace (en Sievert) a partir de laquelle on commence à craindre effectivement pour la santé, c’est à dire de manière constatée et mesurable dans des études sur de grandes populations permettant d’avoir une bonne puissance statistique dans l’évaluation du risque, est de 100 mSv en une seule prise (ou 200 mSv/an si la dose est étalée sur l’année). Avec cette dose là, le nombre de cancer induit est de l’ordre de +0,5% (la règle de proportionnalité est de P = 0,05 D, avec P la proportion de cancer radioinduits et D la dose en Sivert). Concrètement, si je prend 1000 personnes exposées à moins de 100 mSv, j’aurais estimé 400 cancers (c’est en gros le nombre de personnes qui développeront un cancer à la base), sur une vie entière contre 405 si elles sont exposées à 100 mSv .

Avec un poisson farci au taux de 120 kBq/kg, il faut en absorber 60 kg rapidement (au minimum dans l’année) pour arriver au seuil de 100 mSv où on commence à se préoccuper d’un effet possible sur la santé.

Nous

sommes ici assez loin du cataclysme radioactif malgré des doses très

importantes (poissons à la « sortie » de la centrale) et le pire des

scénarios.

Et en France ?

Malgré

le risque de tsunami inexistant en France, il ne faut pas négliger les

leçons de Fukushima : générateurs non-inondables, stratégie en cas de

coupure d’alimentation prolongée (en cas de tempête par exemple) etc.

Nos centrales auraient elles pu encaisser plus efficacement si elles

avaient été dans la même situation ? Il semble que la réponse est

« oui » (pas d’explosion d’hydrogène qui entraîne la perte du

confinement), mais soyons pessimistes.

De

manière générale, notre « gendarme du nucléaire » (ASN) est assez

transparent et bien épaulé par l’ISRN (en appuis technique) dont le site

web regorge de resources intéressantes. En cas de demande populaire, je

pourrai traiter du sujet de manière complète. Le reproche que l’on

pourrait faire est que l’ASN est limité à la sûreté et pas la sécurité

du nucléaire. Cependant, il est compliqué d’obtenir des informations sur

cette dimension sans toucher au domaine du secret-défense.

Alors,

quel est le risque sanitaire du nucléaire en France, après avoir étudié

les conséquences du scénario catastrophe de Fukushima ? Il apparaît bien faible à la lumière de l’étude du pire des scénarios.

Bien entendu, nos réacteurs sont différents et il est difficile de

modéliser exactement les potentiels rejets. Concernant le coût d’un tel

accident, notons le travail réalisé par l’ISRN dans un rapport très détaillé qui n’hésite pas à traiter l’intégralité des conséquences.

Le

principal reproche que je pense être valable est le manque de

communication des acteurs du nucléaire, qui engendre une peur

compréhensible pour qui ne connait que de loin cette énergie, et qui

n’est pas « intuitive » : la radioactivité ne se sent pas et ne se voit

pas , et elle est la descendante des armes atomiques. On fait mieux

comme histoire rassurante. D’ailleurs, combien de morts par quantité

d’énergie produite dans le nucléaire par rapport à d’autres énergies ?

Mise en perspective du risque par énergie

Ici,

nous ne parlons pas de réchauffement, juste de « mortalité » par type

de production d’énergie, afin de vous donner quelques repères sur les

risques.

Alors, combien de morts par million de million (billion) de kWh produits ?

- 100 000 pour le charbon

- 36 000 pour le pétrole

- 24 000 pour la biomasse

- 4000 pour le gaz naturel

- 1400 pour hydroélectricité

- 440 pour le solaire

- 150 pour l’éolien

- 90 pour le nucléaire (en prenant en compte Tchernobyl ET Fukushima)

J’ai surligné la biomasse, car elle fait partie des énergies pivot pour négaWatt afin de se passer du nucléaire (chiffres de l’OMS, principalement pour des raisons de pollution aérienne).

Pour

le fun, vous pouvez voir les conséquences sanitaires de l’abandon du

nucléaire dans les années 80 et d’un retour au charbon au Tennessee

(États-Unis), je vous préviens, c’est pas beau à voir : https://arstechnica.com/science/2017/04/low-birth-weights-found-in-areas-where-coal-replaced-nuclear-power-in-the-80s/

Voici

pour la parenthèse sur le nucléaire, qui est littéralement éjecté par

négaWatt, sans pour autant fournir d’explications détaillées : en fait,

aucune dans le rapport, et seulement quelques une contestables à

l’échelle française en fouillant dans leur site « annexe ». J’aurai aimé

de leur part une vraie justification sur la volonté d’abandonner le

nucléaire, alors que c’est un investissement déjà fait et qui peut

continuer à porter ses fruits, pour à la fois réduire nos émissions de

CO2 et notre dépendance énergétique (il est bon de rappeler que le Canada ou Australie peuvent nous fournir du combustible en quantité suffisante,

et jusqu’ici ce sont des démocraties alliées). En outre, notre seule

dépendance se situe sur le minerai d’uranium: tout le reste de la chaîne

(enrichissement, conversion chimique, assemblages) se déroule en

France. Et tout cela sans parler de la surgénération qui permet de tout simplement résoudre la question de l’approvisionnement. La co-génération est une idée intéressante aussi. Et tout ça, sans risque sanitaire (moins risqué que l’éolien par unité d’énergie produite). Ça vous surprend ? C’est normal.

Avis de déchets

Pour

rappel, les déchets nucléaires sont destinés à être enfouis, par

dispersé dans la décharge de votre commune. À 500 m sous le sol, il n’y a

pas d’impact sur la faune, la flore ou sur la santé. Si vous avez des

études prouvant le contraire, merci de me les faire parvenir.

À ce propos, les trois seuls éléments mobiles sont l’iode-129, le selenium-79 et le chlore-36. L’uranium et le plutonium ne bougent pas une fois mis en stockage profond.

Le site est dimensionné pour que la résurgence de ces isotopes à la

surface se fasse à des niveaux qui n’entraînent aucun impact sur la

santé des populations ou sur l’équilibre de la biosphère.

Et quand à tomber dessus par inadvertance… Au pire, si la mémoire du lieu d’enfouissement se perd, mettons au bout de 1000 ans :

- soit le niveau technologique est bas, et alors y’a pas vraiment moyen d’atteindre des cavités situées 500 m sous le sol (dans des couches sédimentaires compactes, non karstiques)

- soit le niveau technologique est élevé, et par un énorme coup de pas de chance, ils forent pile à cet endroit. Qui d’ailleurs est choisi pour ne présenter aucune ressource minière d’intérêt. Mais, on a dit : ils forent quand même, et re-pas de chance le trépan tombe sur un colis. C’est nettement plus résistant que le reste, mais ils insistent et après avoir cassé plusieurs outils, ils finissent par percer/broyer le colis et remonter un peu de matériau radioactif. L’activité estimée est alors de 100 TBq par colis de 500 kg (elle a été divisée par 500 par rapport au moment de l’enfouissement) soit ~ 0,2 TBq/kg.

Enfin, la surgénération est aussi une réponse possible au traitement de ces déchets.

Les scénarios de négaWatt

Rentrons dans le vif du sujet : quels objectifs sont fixés dans ce rapport, et comment y parvenir. Des chiffres et du concret, c’est très bien !

Énergie éolienne

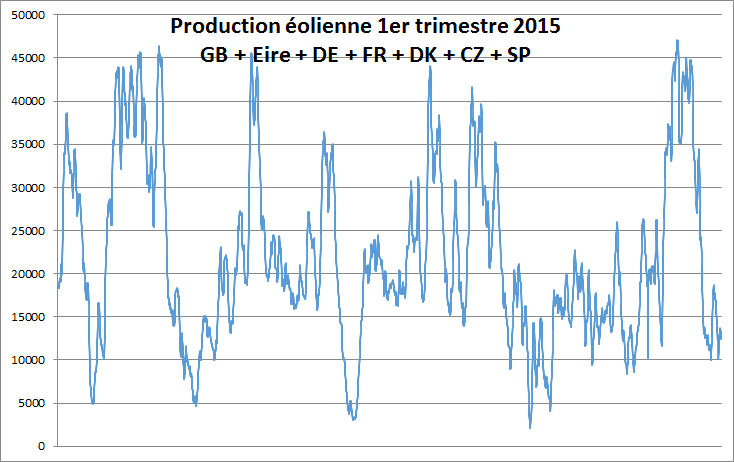

Cette

énergie, en moyenne dans l’année, fournit environ 20% de la capacité

installée (un peu plus en France, un peu moins en Allemagne). Autrement

dit, 10GW d’éoliennes installées fourniront environ 2GW de puissance

disponible lissée sur l’année. Mais cette moyenne cache d’énormes variations : en France en 2016 la puissance minimale fournie était de 0,034 GW (le 23 septembre), la maximale de 8,632 GW (le 20 novembre). Soit un écart de 250 fois.

Cette différence entre capacité installée et puissance disponible est le facteur de charge.

Cette notion est cruciale dans la production électrique, car pour

suivre le besoin (consommation), il ne suffit pas d’installer exactement

la quantité nécessaire. Il faut en installer beaucoup plus pour

l’éolien. Pire encore, quand le vent ne souffle pas, il a tendance à ne

pas souffler partout en Europe. Il ne suffit pas d’installer beaucoup

d’éoliennes. Si aucune (ou presque) ne tourne, vous n’avez plus de quoi

suivre la consommation. Pourtant, négaWatt par du principe de foisonnement des vents à l’échelle européenne. C’est tout simplement faux,

comme on peut le constater dans le graph ci-dessous, qui regroupe la

production électrique éolienne de plusieurs pays européens, le rapport

entre minima et maxima est supérieur à 10 (!) :

On

peut donc se retrouver le bec dans l’eau à avoir 0,01% de la capacité

installée qui produit quand on aurait besoin de 80%. Ouch…

Facteur de charges des autres énergies

Comparons le facteur de charge entre plusieurs énergies (à l’échelle annuelle) et en France :

- Nucléaire : 75%

- Hydroélectrique : 28%

- Éolien : 20%

- Solaire photovoltaïque : 13%

Source : RTE 2012

Et

c’est pas fini : revenons à l’exemple d’un anticyclone d’hiver. Avec

les données RTE de cette année. Par exemple, du 29 décembre 2016 à 12h30

au 2 janvier 2017 à 19h, soit 103 heures, le facteur de charge est toujours resté nettement inférieur à 10% ! Regardons plus en détail :

- Moyenne sur 103 h : 442 MW soit un facteur de charge de 3,8%. Dont 12 heures avec un facteur de charge inférieur à 1% ;

- Consommation France durant ces 103 h : 7359 GWh.

Et en conclusion, participation de l’éolien sur cette période : 45,6 GWh, soit 0,6 %.

Les bons côté de l’éolien

C’est

l’énergie alternative la plus facile à produire et la plus « verte »,

exemple avec son temps de retour énergétique de quelques mois, ce qui

signifie que l’énergie nécessaire de la production d’une éolienne est

« remboursée » en 3 ou 6 mois en gros !

Mais cela ne peut être une solution unique. Pour informations, voici ce que préconise négaWatt :

- Production éolienne en 2015 en France : 20,9 TWh

- Production prévue Negawatt 2050 : 247 TWh soit 12 fois plus.

Pour vous donner un ordre d’idée, à l’heure actuelle, le potentiel éolien est estimé à… 66 TWh sur terre et 90 TWh en mer, donc un total de 156 TWh.

Non

content de multiplier par 12 les éoliennes (il va falloir faire de la

place ! Mais où ?), il faudra aussi dépasser d’une fois et demi notre

potentiel maximum. Par quel miracle ? Il serait intéressant de savoir comment ils veulent y parvenir (c’est une question ouverte, après tout).

Nous

sommes ici au cœur de la problématique de ce rapport, qui reviendra

tout du long : des objectifs au delà du réel sans aucun détail pour

justifier comment les atteindre.

Stockage de l’énergie éolienne?

L’autre

GROS problème est le stockage de l’énergie. Si le vent souffle très

fort alors que la consommation est minime, que faire ? Mais surtout, il

faudra alimenter les foyers, même l’hiver en cas de conditions

anti-cycloniques prolongées (ie pas de vent pendant des semaines,

exactement ce qu’il s’est passé début de 2017). La solution retenue par

négaWatt est le power-to-gas (P2G) sur lequel vous pouvez trouver des détails ici.

Cependant,

il n’existe aucune étude de coûts concernant le stockage en lui-même.

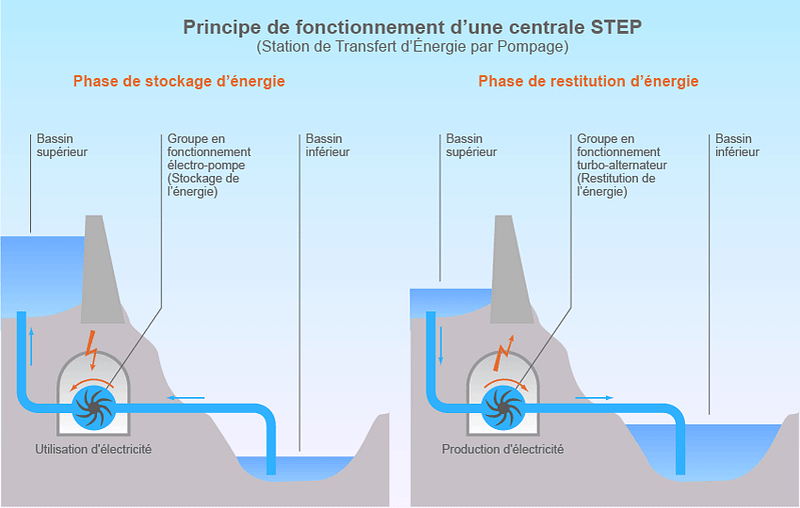

Pour se donner un ordre de grandeur sur la problématique du stockage,

regardons ce qui se fait aujourd’hui principalement : les STEP, ou Stations de transfert d’énergie par pompage.

Le principe est trivial : on stock de l’eau en hauteur et la descendre

va produire de l’énergie (turbinage). Quand on veut stocker plus

d’énergie, on fait remonter plus d’eau (pompage). Simple et efficace :

Regardons maintenant les chiffres sur les STEP en France :

- En 2016 les STEPs ont restitué 5,8 TWh

- En 2050, elles devront restituer 18,3 TWh selon négaWatt

Il faudra donc avoir 3 fois plus de STEP en 2050 qu’aujourd’hui. Ce qui pose 2 gros (très gros) problèmes :

- avec quoi payer ces nouvelles STEP ? Combien cela va coûter ?

- mais surtout, où les mettre ?

En

effet, une STEP possède une faible densité énergétique : c’est à dire

que pour stocker beaucoup d’énergie, il faut beaucoup beaucoup d’eau et

un grand dénivelé entre les deux bassins. Pour vous donner un ordre

d’idée, 1 m³ d’eau à une altitude de 100 m possède une énergie

potentielle de 0,272 kWh (soit 0,000000000000272 TWh par m³).

Les

sites proposant à la fois l’espace et le dénivelé pour ces immenses

volumes d’eau sont plutôt rares en France. Quand à notre potentiel

hydroélectrique, il est déjà bien utilisé, et en ajouter est a priori controversé par rapport à la préservation des masses d’eau. Un sujet à probablement développer qui de toute façon n’entre pas directement dans le rapport de négaWatt.

L’autre alternative pour le stockage (et réduire l’intermittence de la production éolienne) : la méthanation.

Solution proposée là aussi par négaWatt pour gérer ces surplus du vent à

hauteur de 180 TWh. Cependant, cette solution possède de grosses

limitations :

- restitution uniquement sous forme de cogénération in situ (50 TWh en gros)

- stockage plutôt à court terme

Sans oublier que le procédé en lui-même n’a pas encore fait ses preuves à grande échelle ! Cela fait beaucoup d’incertitudes. Cependant, c’est une piste à creuser, car cela peut servir en théorie à tout type d’énergie.

Biomasse

Mais

les auteurs du rapport savent bien que l’éolien tout seul ne sera pas

suffisant, à cause de son facteur de charge et de l’intermittence des

vents (sous-estimé encore une fois via la croyance du foisonnement). On

arrive donc à un autre gros morceau du rapport : la biomasse.

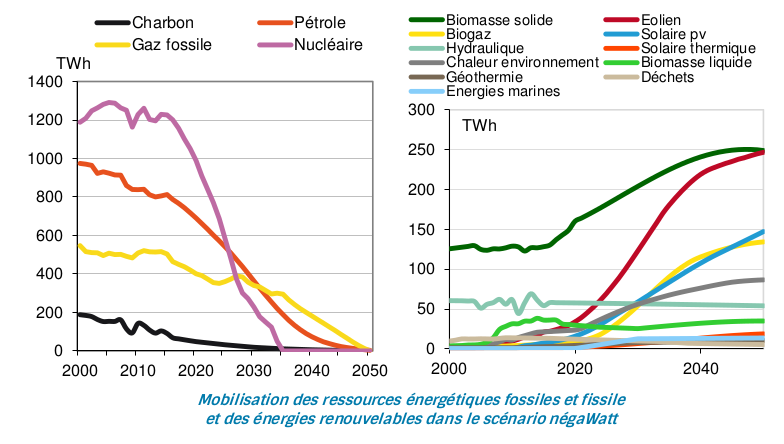

En effet, le scénario est présenté comme ceci :

On

constate donc un objectif à terme d’énergie d’origine biomasse solide

identique à l’éolien, c’est à dire environ 250 TWh. La biomasse solide

dit autrement, c’est le bois. Les chiffres de négaWatt sont-ils réalistes cette fois, contrairement à l’éolien ?

Eh bien la réponse n’est pas simple, c’est même encore bien plus compliqué que pour l’éolien.

J’ai trouvé une critique du rapport de 2011 à cet endroit.

Il semblerait que négaWatt prenne quelques libertés sur les ordres de

grandeurs d’utilisation du bois : l’association part du principe que

tout le bois d’œuvre fini par être brûlé avec un décalage dans le temps

(par exemple, 5 ans pour le coffrage béton, 25 ans pour les isolations

thermiques et 300 ans pour les charpentes). Est-ce réaliste ?

Visiblement tout le monde ne pense pas cela,

mais pour savoir le fond du problème, il faudra probablement passer par

une analyse complète du scénario Afterres2050, qui remet carrément tout

à plat sur l’agriculture en France. Et là, j’avoue, je n’ai pas les

resources pour le faire.

Solaire PV, 3 ème larron en 2050

150

TWh en 2050 pour le solaire photovoltaïque, c’est possible ? Nous

entrons là dans la prédiction sur un domaine qui bouge beaucoup.

Aidons

nous de quelques chiffres : aujourd’hui en France, le solaire PV c’est 8

TWh (en 2016, source RTE). Il s’agirait là de faire quasi 20 fois mieux.

Cela semble possible en respectant les lois de la physique (espace

disponible, amélioration des panneaux et de leur recyclage, meilleur

stockage local, diminution des coûts etc.). Cependant, la vraie question

reste « combien cela coûte par rapport à ce que cela rapporte ». Et là, malheureusement, négaWatt ne fournit pas le moindre élément.

Réduction de la consommation d’énergie

L’autre

grand pan du plan négaWatt, c’est de réduire la consommation d’énergie

globale (pas uniquement électrique). Et pas qu’un peu : réduction de 66% par rapport à 2012. C’est énorme, mais est-ce possible ou pas ?

NégaWatt

voudrait réduire de 850 TWh à l’année la consommation d’énergie totale.

Pour vous donner un ordre de grandeur, la France a produit 563 TWh

d’électricité en 2014.

Par quels moyens atteindre une si grande baisse de consommation ?

Sobriété : économiser 512 TWh

Comment

arriver à ce chiffre énorme ? Voici quelques idées lancées par négaWatt

(elles ne seront pas toutes détaillés ici, le travail est trop

important).

Isoler tous les logements

Le

problème principal de cette vision, c’est son coût ahurissant et son

impossibilité physique. Pour le coût, l’on pourrait calculer l’intérêt

économique d’isoler : si pour 1 kWh économisé cela revient plus cher que

de le produire, ce n’est pas la peine. Bien entendu, il convient

d’isoler le plus de logements dont l’opération tombe sous un seuil rentable

(comparé à produire le dit kWh). Mais le vrai problème est ailleurs :

rénover l’habitat à hauteur de 780 000 logements par an n’est pas

possible. Nous n’avons pas la main d’œuvre suffisante pour y parvenir,

avec pour illustrer cela la promesse de Hollande en 2012, avoir 500 000

logements rénovés. Celle-ci n’ayant pu être tenue de part ce fait (au

final, le rythme est quasi 4 fois moins élevé que prévu et avec des

performances moindres).

Réduire la consommation du résidentiel

Arriver

à réduire de 46% (!) la consommation moyenne par ménage, avec

l’optimisation des usages, sans impact de confort. C’est énorme, même en

incluant l’efficacité énergétique dans ces 46%. Sans parler de la mise

en œuvre de politiques incitatives « encourageant par exemple la colocation d’étudiants ou l’hébergement de jeunes travailleurs chez des personnes âgées ». La mise en œuvre d’une telle politique semble compliquée.

Transports

Ici,

pas d’idées saugrenues ou irréalisables dans l’absolu : réduction de la

vitesse sur route et autoroute (respectivement 80 et 110 km/h), mais

surtout :

- tripler l’utilisation de 2 roues (motorisés ou non) ;

- diviser par 2 l’utilisation des voitures hors zone urbaines ;

- diviser par 2,5 l’utilisation de l’avion ;

- doubler l’utilisation du TGV.

En

soi, c’est possible. Maintenant, le seul moyen de convaincre les gens

de changer leur mode de transport (cela ne se décrète pas dans une

démocratie), est le levier du coût. Et donc in fine, augmenter le coût de l’énergie. Malheureusement, c’est une mesure politiquement très délicate (bien que souhaitable !).

Efficacité demande : 334 TWh en moins

Cela

concerne l’amélioration des appareils « finaux » (moteurs, voitures par

exemple), avec l’utilisation en priorité des moins énergivores. Sur 33

ans, il est difficile d’infirmer ou d’affirmer les progrès en la

matière. Je ne souhaite donc pas critiquer ce chiffre, manquant

d’éléments.

Efficacité offre : 465 TWh de gagné

Ici

on parle d’amélioration des moyens de production. La technologie va

forcément nous apporter des améliorations, dans quelle mesure, difficile

à dire là aussi. Je m’abstiens donc de commentaire sur ce chiffre.

Conclusion

On

voit ici que négaWatt, en décidant de se séparer du nucléaire dès le

départ, doit tordre la réalité au maximum pour « rentrer dans les

cases » : il faut réduire énormément la consommation pour pouvoir utiliser uniquement du renouvelable.

Le problème, c’est que ces économies ne sont même pas suffisantes ! On

l’a vu pour l’éolien, les chiffres ne sont pas réalistes. Sans oublier

la contrainte du stockage qui est loin d’être résolue à l’heure

actuelle.

Concernant les choix économiques, un bon résumé de « l’esprit » du rapport, page 13 :

Sur le plan économique, le réalisme consiste paradoxalement à s’affranchir des limites imposées par les règles actuellement reflétées dans les modèles d’analyse macro-économique.

Le

rapport manque ici un point important : certes, pourquoi pas mettre en

place une alternative macro-économique, mais il faut d’abord choisir ses

paramètres puis tenter de démontrer sa pertinence. Ce qui n’est

malheureusement pas fait.

Au final, le constat de départ est partagé : la priorité doit être faite pour décarboner notre économie.

Cependant, les moyens pour y parvenir en terme de production électrique

sont soit -au mieux- en dehors de toute réalité économique (assumée qui

plus est !), soit -au pire- en dehors de toute réalité tout court. Il est possible de débattre sur les choix économiques, mais les lois de la physique n’ont pas d’opinion.

Aucun commentaire:

Enregistrer un commentaire